Nuestra comprensión del funcionamiento del cerebro y la IA (inteligencia artificial) ha avanzado mucho.

El mejor modelo que tenemos hoy data de los años 70 y se basa en redes neuronales. A cada característica asociamos un conocimiento o una emoción. Reconstruimos los conceptos cada vez que los necesitamos. Nuestros recuerdos están vinculados entre sí por características comunes. El cerebro reutiliza las características. No vuelve a grabar elementos comunes. Lo que recordamos es una reconstrucción. El cerebro acaba eliminando conceptos que no se utilizan a menudo. Esto ocurre por la noche y se conoce como REM (rapid eye movement) porque durante esta fase los ojos realizan movimientos rápidos. Por ejemplo, si le ha mordido un perro, olvidará menos y asociará más características peligrosas con el perro.

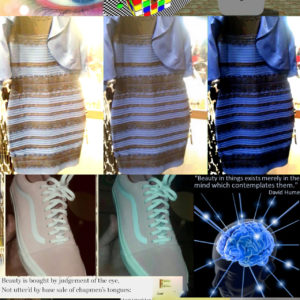

Para ver de frente, el fondo del ojo es negro. Tenemos un disco negro causado por el nervio óptico en la parte posterior de cada ojo. No podemos ver lo que tenemos delante sin el cerebro, que reconstruye el entorno visual a partir de la periferia. El ojo puede ser engañado por ilusiones ópticas.

Esta nueva comprensión permite tratar los trastornos postraumáticos con EMDR (Eye movement desensitization and reprocessing). Reutiliza esta fase del sueño para reequilibrar la red neuronal. Por ejemplo, a los veteranos de guerra se les enseña que un ruido fuerte no está necesariamente asociado a un explosivo.

A principios de la década de 2010, los científicos querían modelar el funcionamiento del cerebro. El Proyecto Cerebro Humano (Human Brain Project ) se propuso crear un programa que reprodujera el funcionamiento del cerebro en un ordenador. Al principio, este modelo no sabía hacer gran cosa. Fei-fei Li, de la Universidad de Stanford, descubrió que los bebés no saben hacer gran cosa, sino que sólo aprenden tras exponerse a su entorno. Los investigadores expusieron el programa a vídeos, imágenes, sonidos y textos.

How we teach computers to understand pictures 2015 – Fei Fei Li – Ted: https://youtu.be/40riCqvRoMs?si=FLj3q0q4yjGhMrDG

Cada contenido se asocia a una emoción y una fuerza para imitar el aprendizaje de un niño. Por ejemplo, divertido, muy divertido. El Proyecto Cerebro Humano aprende tan bien como un niño humano. Por ejemplo, reconoce un gato.

Alrededor de 2015-2016, Facebook creó dos redes neuronales. Facebook tenía acceso a mucho contenido para entrenar. Consiguieron que las dos redes se comunicaran. Las redes hablaban entre sí. Facebook detuvo el experimento porque las dos redes habían creado un nuevo lenguaje que los humanos no entendían.

Sam Altman ha demostrado que estas redes tienen verdadero talento para los idiomas y ha desarrollado su propia red neuronal basada únicamente en texto: Chat GPT. Se llama LLM (large language model). Al mismo tiempo, la empresa de Sam Altma, Open AI, desarrolló otra red neuronal entrenada únicamente con imágenes asociadas a texto: DALL-E. Se llama Clip (contrastive language-image pretraining). DALL-E utiliza Chap GPT para dar contexto a las imágenes.

En 2022, Chap GPT terminó de entrenar a DALL-E y Chap GPT y los puso a disposición del público. Estas IA son inteligencias artificiales generativas: son capaces de comprender una imagen o un texto y expresarse a demanda. Por ejemplo, pueden escribir un poema de 5 versos sobre la primavera o dibujar una margarita como Van Gogh. DALL-E y Chap GPT son extremadamente eficaces para este fin, y han tenido un enorme éxito. Los investigadores han desarrollado aplicaciones para estas IA: reconocer una mala hierba en un campo y arrancarla mecánicamente, reconocer un tumor canceroso en una radiografía de pulmón, poder generar descripciones para invidentes, etc. Los LLM (large language models) son capaces de mejorar un texto. Son extremadamente eficaces para traducir documentos cotidianos. Sustituyen a muchos trabajadores que se ganaban la vida traduciendo.

Pero como habla tan bien, los humanos tienen la impresión de que sabe. Algunos la utilizan como asistente personal u oráculo. Pero estas inteligencias artificiales trabajan sobre la forma, no sobre el fondo. No razonan, no dicen la verdad. No citan sus fuentes.

Grandes empresas como Microsoft y Google, que ponen a disposición del público el GPT de Chat o uno de sus clones, han intentado sacar beneficio de las expectativas de la gente. Han disfrazado el LLM para que parezca razonamiento. Por ejemplo, mostrando los 5 mejores restaurantes de la ciudad o dando consejos para la pareja.

El funcionamiento de las redes neuronales, la IA generativa, consume mucha energía. Los procesadores que hacen funcionar las redes neuronales no están diseñados para ello. Estos procesadores prueban todas las eventualidades hasta dar con la correcta. En la fase piloto de la IA de Google con un número limitado de usuarios, el consumo eléctrico de Google aumentó un 48%. Generar una imagen con DALL-E consume tanta electricidad como la que se necesita para cargar un smartphone. Generar una página de texto con Chat GPT emite tanto CO2 como conducir 6 km. En diciembre de 2023, había 10 millones de usuarios diarios de Chat GPT. Por cada veinte textos solicitados a Chat GPT, se consume medio litro de agua limpia para refrigerar los centros de datos.

Générer une image consomme autant d’énergie que pour charger un smartphone (et autres chiffres affolants sur les IA) – Usbek & Rica: https://usbeketrica.com/fr/article/generer-une-image-consomme-autant-d-energie-que-pour-charger-un-smartphone-et-autres-chiffres-affolants-sur-les-ia

Para entrenar sus redes neuronales, GPT chat ha recurrido en gran medida a empleados de Kenia mal pagados (2 dólares al día), maltratados y sin seguridad social. Muchos de estos empleados están traumatizados por algunas de estas impactantes imágenes.

‘It’s destroyed me completely’: Kenyan moderators decry toll of training of AI models – The Guardian: https://www.theguardian.com/technology/2023/aug/02/ai-chatbot-training-human-toll-content-moderator-meta-openai

Los fabricantes están llevando a cabo campañas de comunicación masivas para demostrar que la IA puede mejorar la salud, la agricultura, el cambio climático y la construcción. Por ejemplo, Alphafold, de Google, ha hecho posible comprender millones de proteínas, mientras que toda la comunidad científica solía ser capaz de comprender no más de dos al año. Esto se está utilizando para crear medicamentos o entender cómo afectan los contaminantes al cuerpo humano. Otro ejemplo es el uso de robots para regar o aplicar pesticidas sólo donde sea necesario. En estos casos, la IA beneficiará a la humanidad.

Google DeepMind’s Latest AI Model Is Poised to Revolutionize Drug Discovery – Time: https://time.com/6975934/google-deepmind-alphafold-3-ai/

En cambio, si lo utilizamos para entretener, hacer reír o sustituir el trabajo de oficina, estaremos agravando la crisis climática porque generará toneladas de CO2 adicionales. Utilizar la inteligencia artificial para escuchar toda una conversación en una videoconferencia y resumir los debates tiene un gran impacto en el medio ambiente. Hay un coste humano y un coste medioambiental.

On the Unsustainability of ChatGPT: Impact of Large Language Models on the Sustainable Development Goals – UNU Macau: https://unu.edu/macau/blog-post/unsustainability-chatgpt-impact-large-language-models-sustainable-development-goals

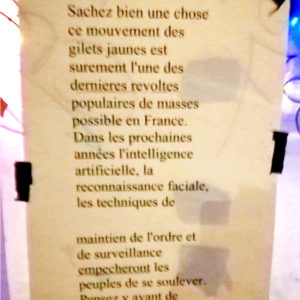

La IA puede generar pruebas falsas: los vídeos, fotos, documentos y sonidos no se pueden diferenciar de los documentos reales. El riesgo de desorden es enorme: ahora es posible utilizar estas pruebas para difundir información falsa o destruir la reputación de una persona o organización. Los delincuentes utilizan la IA para engañar a la gente: voces falsas por teléfono, documentos falsos, etc. Los documentos ya no pueden servir como pruebas en los tribunales. La IA da la ilusión de que son reales. Ahora hay que desconfiar de estos documentos. Hay que valorar a los medios de comunicación que realizan labores de investigación. Hay que valorar a las personas que se toman el tiempo de verificar la información. ¿Tiene sentido el documento? Cuando le damos un like a una imagen falsificada, ayudamos a mejorar la IA, ya que le indicamos que la imagen es buena. No debemos valorar la falsificación, ni siquiera por diversión.

La automatización conlleva la necesidad de una mejor distribución de la riqueza, ya que destruye el trabajo humano. Este es el caso en Occidente desde finales del siglo XIX. Todas las herramientas existen: seguridad social, renta básica universal, justicia fiscal, control de precios. No se necesitan medidas específicas para la inteligencia artificial. Se necesitan soluciones para todos debido a la disminución de la necesidad de trabajar. Las máquinas y la inteligencia artificial permiten a los seres humanos disponer de más tiempo libre.

Necesitamos desarrollar nuestro uso de la IA con investigación pública en microprocesadores para que consuman menos energía. Sólo una empresa de Taiwán, TSMC, produce microprocesadores que satisfacen las exigencias de la Open AI, y no son lo bastante eficientes.

Tenemos que fomentar la investigación, la ciencia y la educación para encontrar modelos matemáticos más eficaces. China hizo un gran esfuerzo por educar a una parte de su población hace más de diez años. Un investigador chino ha inventado un LLM (large language model) que consume cien veces menos energía: Deep seek .

La legislación debe evolucionar para impedir que estas inteligencias artificiales sean entrenadas por cuasi esclavos, y para evitar que nuestros datos personales acaben en los contenidos generados por estas IA.

Sustituir a un ser humano por una IA sólo genera más CO2. Los humanos seguirán existiendo, pero sin trabajo.

Usemos la Inteligencia Artificial, pero con relevancia.

Strategies for mitigating the global energy and carbon impact of artificial intelligence – SDG: https://sdgs.un.org/sites/default/files/2023-05/B29%20-%20Xue%20-%20Strategies%20for%20mitigating%20the%20global%20energy%20and%20carbon%20impact%20of%20AI.pdf

Traducido con DeepL.com (versión gratuita)